BI-ML1

Created by Honza Šuráň

Binarni klasifikace

Pokracovani LR

- odolna vuci vysoke dimenzionalite

- pro

priznaku muze stacit

priznaku muze stacit  trenovacich bodu pro natrenovani

trenovacich bodu pro natrenovani - pokud jsou ale priznaky kolinearni, pak

bud neni linearni, nebo je vysoce numericky nestabilni, a inverze se pocita blbe

bud neni linearni, nebo je vysoce numericky nestabilni, a inverze se pocita blbe

Gini index (Gini impurity)

- neco jako rozptyl pro Bernoulliho rozdeleni

- chci co nejmensi "rozptyl" v podmnozinach - jak moc dobre klasifikovan bude novy prvek/jak moc jsou podmnoziny homogenni

Linearni regrese

Vyber priznaku

- slouzi k redukci priznaku a dimenze

- supervizovane i nesupervizovane

Vestavene metody

- vyuzivaji model, ktery se trenuje pouze jednou na celych datech a pri tom implicitne provede vyber priznaku

- funguje tak, ze se implicitne nauci nektere priznaky vubec nevyuzivat

- napr. u linearni regrese jsou prislusne koeficienty odhadnuty jako nulove

Nestrannost metody nejmensich ctvercu

- Veta: odhad

ziskany metodou nejmensich ctvercu je za predpokladu

ziskany metodou nejmensich ctvercu je za predpokladu  nestranny, tj.

nestranny, tj.

- Dukaz:

![\begin{align}

\text{E} \mathbf{Y} = \text{E}\left(\mathbf{X} \mathbf{w} + \mathbf{\epsilon} \right) &= \mathbf{X} \mathbf{w} + \text{E} \mathbf{\epsilon} = \mathbf{X} \mathbf{w} \\[7pt]

\text{E} \hat{\mathbf{w}}_{OLS}

&= \text{E}\left(\mathbf{X}^T X \right)^{-1} \mathbf{X}^T \mathbf{Y} \\

&= \left(\mathbf{X}^T\mathbf{X}\right)^{-1} \mathbf{X}^T \text{E } \mathbf{Y} \\

&= \left(\mathbf{X}^T \mathbf{X}\right)^{-1} \mathbf{X}^T\mathbf{X}\mathbf{w} \\

&= \mathbf{w}

\end{align}](data:image/svg+xml;base64,PHN2ZyB4bWxuczp4bGluaz0iaHR0cDovL3d3dy53My5vcmcvMTk5OS94bGluayIgd2lkdGg9IjM1LjY4OGV4IiBoZWlnaHQ9IjE5LjUwOWV4IiBzdHlsZT0idmVydGljYWwtYWxpZ246IC05LjE3MWV4OyIgdmlld0JveD0iMCAtNDQ1MS4xIDE1MzY1LjYgODM5OS44IiByb2xlPSJpbWciIGZvY3VzYWJsZT0iZmFsc2UiIHhtbG5zPSJodHRwOi8vd3d3LnczLm9yZy8yMDAwL3N2ZyI+CjxkZWZzPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi00NSIgZD0iTTU5NyAxNjlsLTQ2IC0xNjloLTUzOXYxOWM3NyA1IDg3IDE4IDg3IDk1djQzNmMwIDc0IC0xMiA4OSAtODcgOTN2MTloNTMwbDQgLTE0M2gtMjVjLTE1IDkwIC0zOCAxMDUgLTE1NCAxMDVoLTEzMWMtMjggMCAtMzUgLTQgLTM1IC0zNnYtMjIwaDE1MWM4NiAwIDEwMSAxNyAxMTMgOTZoMjN2LTIzNGgtMjNjLTEyIDg0IC0yNyA5NyAtMTEzIDk3aC0xNTF2LTI0M2MwIC00MiAyNyAtNDcgMTAxIC00N2gzNmMxNDMgMCAxODYgMjYgMjMxIDEzMiBoMjhaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJOT1JNQUxCLTFENDE4IiBkPSJNNjk5IDY3NnYtMjVjLTM0IC01IC01NCAtMTYgLTY4IC0zOWwtMTkxIC0zMTF2LTE3OGMwIC03OCAxMyAtOTEgOTIgLTk4di0yNWgtMzQ3djI1YzgzIDcgOTMgMjggOTMgMTAzdjEzNmwtMTgwIDMyOGMtMTkgMzQgLTQ5IDU3IC04MyA1OXYyNWgzMzV2LTI1bC0yNyAtMmMtNDAgLTMgLTU0IC02IC01NCAtMjljMCAtOSAxMiAtMzYgMjQgLTU5bDEyMCAtMjMybDEwOSAxNzhjMjYgNDMgNDEgODIgNDEgMTAyYzAgMjkgLTE2IDM3IC04NCA0MnYyNSBoMjIwWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0zRCIgZD0iTTYzNyAzMjBoLTU4OXY2Nmg1ODl2LTY2ek02MzcgMTIwaC01ODl2NjZoNTg5di02NloiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtU1RJWFdFQk1BSU4tMjgiIGQ9Ik0zMDQgLTE2MWwtMTIgLTE2Yy0xNTggOTAgLTI0NCAyNTkgLTI0NCA0MjljMCAxODUgODcgMzI5IDI0NyA0MjRsOSAtMTZjLTEzOSAtMTE5IC0xNzAgLTIxMiAtMTcwIC00MDVjMCAtMTg2IDMwIC0yOTkgMTcwIC00MTZaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJOT1JNQUxCLTFENDE3IiBkPSJNNjk5IDBoLTM0MHYyNWwyOCAyYzM1IDIgNTIgMTEgNTIgMjhjMCAxMiAtOSAzNSAtMjEgNTRsLTEwMSAxNjJsLTM4IC01MWMtNzUgLTEwMSAtOTQgLTEzMiAtOTQgLTE1M2MwIC0yNiAyMCAtMzYgODEgLTQydi0yNWgtMjUwdjI1YzUwIDYgNzQgMTkgMTA0IDU2bDE3NSAyMjFsLTE5OCAyOTFjLTMxIDQ1IC00NCA1NSAtODAgNTh2MjVoMzQ2di0yNWwtMzEgLTJjLTM2IC0yIC00OCAtMTAgLTQ4IC0zMWMwIC0xMiAyIC0xNyAxNSAtMzcgbDk3IC0xNTBsNTYgNzdjNDcgNjUgNTggODQgNTggMTA2YzAgMjQgLTEzIDMxIC01MSAzNWwtMjEgMnYyNWgyNTB2LTI1Yy03NSAtNyAtMTAxIC0yNSAtMTg4IC0xNDZsLTgwIC0xMTFsMTgyIC0yODNjNDcgLTczIDYzIC04NSA5NyAtODZ2LTI1WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTk9STUFMQi0xRDQzMCIgZD0iTTcwNyA0NjF2LTI0Yy0yNiAtNSAtMzcgLTE2IC01MCAtNTBsLTE1NSAtNDAxaC0yM2wtMTAyIDMxMGwtMTI1IC0zMTBoLTI0bC0xNDggMzc0Yy0yNSA2MiAtMzEgNzIgLTU3IDc3djI0aDIyMnYtMjRjLTI4IC00IC0zOCAtMTEgLTM4IC0yOGMwIC0xMyAxMiAtNDQgMzkgLTExNWw0NSAtMTE4bDY4IDE3MWMtMiA2IC00IDEyIC02IDE5Yy0xOSA2NiAtMjAgNjcgLTU5IDcxdjI0aDIzNHYtMjRjLTM4IC0zIC00OCAtOCAtNDggLTI0IGMwIC0xMCA3IC0zOCAyNyAtMTA2YzIwIC03MCAyNCAtODUgMzQgLTEyN2wzNSA5NGMyOSA3OCA0NCAxMTUgNDQgMTI4YzAgMjMgLTExIDMxIC00OCAzNXYyNGgxMzVaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJNQUlOLTJCIiBkPSJNNjM2IDIyMGgtMjYxdi0yNjFoLTY2djI2MWgtMjYxdjY2aDI2MXYyNjFoNjZ2LTI2MWgyNjF2LTY2WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTk9STUFMSS0xRDcxNiIgZD0iTTQzMCA0NDFsLTE5IC0xMzJoLTE1Yy03IDQ2IC0yNCAxMDUgLTkzIDEwNWMtODIgMCAtMTM5IC05NyAtMTYxIC0xNjdoMTgxbC01IC0zNmgtMTg1Yy03IC0yMCAtNyAtNDEgLTcgLTY2YzAgLTY0IDM3IC0xMDEgOTIgLTEwMWM1OCAwIDEwOSAzNCAxNDQgNjhsMTIgLTE0Yy01MyAtNjAgLTExMSAtMTA5IC0xOTQgLTEwOWMtOTQgMCAtMTQwIDY5IC0xNDAgMTUyYzAgMTQyIDExNCAzMDAgMjY5IDMwMGM0OSAwIDU1IC0yMCA4MyAtMjAgYzEyIDAgMTkgMTEgMjMgMjBoMTVaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJNQUlOLTI5IiBkPSJNMjkgNjYwbDEyIDE2YzE1MyAtOTIgMjQ0IC0yNTkgMjQ0IC00MjljMCAtMTg1IC04OCAtMzI3IC0yNDcgLTQyNGwtOSAxNmMxNDIgMTE3IDE3MCAyMTEgMTcwIDQwNWMwIDE4NyAtMjUgMzAyIC0xNzAgNDE2WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0zMDIiIGQ9Ik0tNzUgNTA3aC0zNGwtMTIyIDEwM2wtMTIxIC0xMDNoLTM0bDEyNCAxNjdoNjJaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJOT1JNQUxJLTFENDQyIiBkPSJNNzEyIDQyMGMwIC0xOTggLTE1NiAtNDMxIC00MDkgLTQzMWMtMTQ5IDAgLTI1MyA5NiAtMjUzIDIzM2MwIDIwMyAxNTggNDQ3IDQxMyA0NDdjMTY3IDAgMjQ5IC0xMjMgMjQ5IC0yNDl6TTU5NiA0NDNjMCAxMDcgLTQwIDE4OSAtMTQxIDE4OWMtMjMyIDAgLTI4NCAtMzEzIC0yODQgLTQ1NWMwIC05NyA2MiAtMTUwIDE0MCAtMTUwYzIxMiAwIDI4NSAyNzUgMjg1IDQxNloiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtU1RJWFdFQk5PUk1BTEktMUQ0M0YiIGQ9Ik02NjggMTkwbC02MSAtMTkwaC01NjlsNCAxNmgxN2M3NSAwIDk5IDI4IDEwNyA2MmwxMTggNDc3YzQgMTYgNyAzNiA3IDQ1YzAgMTkgLTE0IDM3IC03NiAzN2gtMThsNCAxNmgzMjdsLTQgLTE2aC0xOGMtNzUgMCAtOTYgLTI2IC0xMDUgLTYzbC0xMjIgLTQ4MWMtNCAtMTUgLTUgLTI5IC01IC0zMWMwIC0yMiAyOCAtMjQgNDAgLTI0aDEyMmMxMDIgMCAxNTMgMjIgMTk5IDExNWM3IDExIDEyIDIzIDE3IDM3aDE2WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTk9STUFMSS0xRDQ0NiIgZD0iTTY4MCA2NjhsLTUzIC0yMjFoLTE2YzEgOCAxIDE2IDEgMjRjMCA4NCAtNDggMTYwIC0xNjAgMTYwYy00MyAwIC0xMjEgLTI2IC0xMjEgLTk3YzAgLTY5IDYxIC0xMTEgMTE3IC0xNTljNTkgLTQ5IDExOCAtMTA3IDExOCAtMTk0YzAgLTk5IC04NyAtMTkxIC0yNDQgLTE5MWMtOTQgMCAtMTI1IDM4IC0yMDEgMzhjLTI1IDAgLTM5IC0xMSAtNTUgLTM4aC0xNmw2MCAyMzZoMTZjMCAtMTAgMSAtMjEgMSAtMzEgYzMgLTc5IDQwIC0xNjcgMTcxIC0xNjdjMTI3IDAgMTU2IDcxIDE1NiAxMzZjMCAzNSAtMTggNjggLTQ2IDk2Yy0zMCAzMSAtNzggNjcgLTExNCAxMDJjLTI4IDI4IC03MyA4MiAtNzMgMTMxYzAgODEgNjUgMTc1IDIyMyAxNzVjODMgMCAxNDAgLTM3IDE4MyAtMzdjMjAgMCAzNCAyMiAzNyAzN2gxNloiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtU1RJWFdFQk5PUk1BTEktMUQ0NDciIGQ9Ik02NzAgNjUzbC00NiAtMTc5aC0xNmMyIDE3IDUgNDQgNSA3MWMwIDY2IC01OCA3MSAtOTkgNzFoLTk4bC0xMzMgLTUzOGMtMiAtOSAtNSAtMTYgLTUgLTI1YzAgLTIxIDE2IC0zNyA3NiAtMzdoMjFsLTQgLTE2aC0zMjlsNCAxNmgxOGM3OCAwIDk4IDI4IDEwNiA2MmwxMzMgNTM4aC05MWMtODMgMCAtMTUzIC02MSAtMTcxIC0xNDJoLTE2bDQ2IDE3OWg1OTlaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJOT1JNQUxJLTFENDRCIiBkPSJNODEwIDY1M2wtNCAtMTZoLTRjLTY5IDAgLTk4IC0zMiAtMTM1IC03NGwtMTg3IC0yMTNsOTYgLTI2NmMxMiAtMzQgMjkgLTY4IDc5IC02OGgxNGwtNCAtMTZoLTI4MWw0IDE2aDExYzM4IDAgNjcgNCA2NyA0MWMwIDggLTEgMTYgLTQgMjZsLTY5IDE5NGwtMTgxIC0yMDFjLTkgLTEwIC0xMiAtMTkgLTEyIC0yOGMwIC0xOSAxOCAtMzIgNTYgLTMyaDIybC00IC0xNmgtMjQ5bDQgMTZjNTQgNyAxMDMgMzcgMTQwIDc3bDIwOCAyMzBsLTg1IDIzMSBjLTExIDMxIC0yOCA4MyAtMTAyIDgzaC05bDQgMTZoMjgzbC00IC0xNmgtMTljLTMwIDAgLTUyIC00IC01MiAtMzVjMCAtOCAyIC0xNyA2IC0yOGw2MCAtMTc5bDE2NCAxODRjOSAxMSAxNSAyMyAxNSAzNGMtMSAxNiAtMTMgMjQgLTQ1IDI0aC05bDQgMTZoMjIyWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCU0laRTEtMjgiIGQ9Ik0zODIgLTEzNHYtMzBjLTE0MiAxMzQgLTI0MyAzNDMgLTI0MyA2MTVjMCAyNjcgMTAxIDQ4MSAyNDMgNjE1di0zMGMtOTAgLTExMCAtMTYyIC0yODIgLTE2MiAtNTg1YzAgLTMwNiA3MiAtNDc1IDE2MiAtNTg1WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCU0laRTEtMjkiIGQ9Ik04NiAxMDM2djMwYzE0MiAtMTM0IDI0MyAtMzQzIDI0MyAtNjE1YzAgLTI2NyAtMTAxIC00ODEgLTI0MyAtNjE1djMwYzkwIDExMCAxNjIgMjgyIDE2MiA1ODVjMCAzMDYgLTcyIDQ3NSAtMTYyIDU4NVoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtU1RJWFdFQk1BSU4tMjIxMiIgZD0iTTYyMSAyMjBoLTU1N3Y2Nmg1NTd2LTY2WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0zMSIgZD0iTTM5NCAwaC0yNzZ2MTVjNzQgNCA5NSAyNSA5NSA4MHY0NDljMCAzNCAtOSA0OSAtMzAgNDljLTEwIDAgLTI3IC01IC00NSAtMTJsLTI3IC0xMHYxNGwxNzkgOTFsOSAtM3YtNTk3YzAgLTQzIDIwIC02MSA5NSAtNjF2LTE1WiI+PC9wYXRoPgo8L2RlZnM+CjxnIHN0cm9rZT0iY3VycmVudENvbG9yIiBmaWxsPSJjdXJyZW50Q29sb3IiIHN0cm9rZS13aWR0aD0iMCIgdHJhbnNmb3JtPSJtYXRyaXgoMSAwIDAgLTEgMCAwKSI+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDE2NywwKSI+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKC0xMSwwKSI+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDAsMzU3MCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tNDUiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk5PUk1BTEItMUQ0MTgiIHg9IjYxMSIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zRCIgeD0iMTYxMSIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi00NSIgeD0iMjU3NSIgeT0iMCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDMzNTMsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMjgiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk5PUk1BTEItMUQ0MTciIHg9IjMzMyIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTk9STUFMQi0xRDQzMCIgeD0iMTA1NiIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0yQiIgeD0iMjAwMCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTk9STUFMSS0xRDcxNiIgeD0iMjkwOCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0yOSIgeD0iMzMzOCIgeT0iMCI+PC91c2U+CjwvZz4KPC9nPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg0MDkxLDEyODkpIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTQ1IiB4PSIwIiB5PSIwIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoNjExLDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxCLTFENDMwIiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTMwMiIgeD0iNTUzIiB5PSI2MyI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDcyMiwtMTUwKSI+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtU1RJWFdFQk5PUk1BTEktMUQ0NDIiIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxJLTFENDNGIiB4PSI3MzIiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxJLTFENDQ2IiB4PSIxNDQxIiB5PSIwIj48L3VzZT4KPC9nPgo8L2c+CjwvZz4KPC9nPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg3MDE1LDApIj4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMCwzNTcwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zRCIgeD0iMjc3IiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxCLTFENDE3IiB4PSIxMjQxIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxCLTFENDMwIiB4PSIxOTYzIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTJCIiB4PSIyOTA4IiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTQ1IiB4PSIzODE2IiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxJLTFENzE2IiB4PSI0NDI3IiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTNEIiB4PSI1MTM1IiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxCLTFENDE3IiB4PSI2MDk5IiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxCLTFENDMwIiB4PSI2ODIxIiB5PSIwIj48L3VzZT4KPC9nPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgwLDEyODkpIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTNEIiB4PSIyNzciIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tNDUiIHg9IjEyNDEiIHk9IjAiPjwvdXNlPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSgxODUyLDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJTSVpFMS0yOCIgeD0iMCIgeT0iLTIwMSI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDQ2OCwwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTk9STUFMQi0xRDQxNyIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtU1RJWFdFQk5PUk1BTEktMUQ0NDciIHg9IjEwMjEiIHk9IjU4MyI+PC91c2U+CjwvZz4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxJLTFENDRCIiB4PSIxNzY1IiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJTSVpFMS0yOSIgeD0iMjU3NSIgeT0iLTIwMSI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDMwNDQsNjAyKSI+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMjIxMiIgeD0iMCIgeT0iMCI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC43MDcpIiB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMzEiIHg9IjY4NSIgeT0iMCI+PC91c2U+CjwvZz4KPC9nPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg1ODM1LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxCLTFENDE3IiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTk9STUFMSS0xRDQ0NyIgeD0iMTAyMSIgeT0iNTgzIj48L3VzZT4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk5PUk1BTEItMUQ0MTgiIHg9IjcxMzEiIHk9IjAiPjwvdXNlPgo8L2c+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDAsLTQ1OCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tM0QiIHg9IjI3NyIgeT0iMCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDEyNDEsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQlNJWkUxLTI4IiB4PSIwIiB5PSItMjAxIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoNDY4LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxCLTFENDE3IiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTk9STUFMSS0xRDQ0NyIgeD0iMTAyMSIgeT0iNTgzIj48L3VzZT4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk5PUk1BTEItMUQ0MTciIHg9IjE3NjUiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQlNJWkUxLTI5IiB4PSIyNDg3IiB5PSItMjAxIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMjk1Niw2MDIpIj4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0yMjEyIiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zMSIgeD0iNjg1IiB5PSIwIj48L3VzZT4KPC9nPgo8L2c+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDUxMzUsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk5PUk1BTEItMUQ0MTciIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxJLTFENDQ3IiB4PSIxMDIxIiB5PSI1ODMiPjwvdXNlPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi00NSIgeD0iNjQzMiIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTk9STUFMQi0xRDQxOCIgeD0iNzI5MyIgeT0iMCI+PC91c2U+CjwvZz4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMCwtMjIwNSkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tM0QiIHg9IjI3NyIgeT0iMCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDEyNDEsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQlNJWkUxLTI4IiB4PSIwIiB5PSItMjAxIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoNDY4LDApIj4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxCLTFENDE3IiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTk9STUFMSS0xRDQ0NyIgeD0iMTAyMSIgeT0iNTgzIj48L3VzZT4KPC9nPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk5PUk1BTEItMUQ0MTciIHg9IjE3NjUiIHk9IjAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQlNJWkUxLTI5IiB4PSIyNDg3IiB5PSItMjAxIj48L3VzZT4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMjk1Niw2MDIpIj4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0yMjEyIiB4PSIwIiB5PSIwIj48L3VzZT4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjcwNykiIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zMSIgeD0iNjg1IiB5PSIwIj48L3VzZT4KPC9nPgo8L2c+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDUxMzUsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk5PUk1BTEItMUQ0MTciIHg9IjAiIHk9IjAiPjwvdXNlPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNzA3KSIgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJOT1JNQUxJLTFENDQ3IiB4PSIxMDIxIiB5PSI1ODMiPjwvdXNlPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTk9STUFMQi0xRDQxNyIgeD0iNjQzMiIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTk9STUFMQi0xRDQzMCIgeD0iNzE1NCIgeT0iMCI+PC91c2U+CjwvZz4KPGcgdHJhbnNmb3JtPSJ0cmFuc2xhdGUoMCwtMzY3MSkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tM0QiIHg9IjI3NyIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTk9STUFMQi0xRDQzMCIgeD0iMTI0MSIgeT0iMCI+PC91c2U+CjwvZz4KPC9nPgo8L2c+CjwvZz4KPC9zdmc+)

- Veta: Predikce je take nestranna:

- dusledek: vychyleni je nulove:

Mira neusporadanosti, entropie, informacni zisk

hyperparametry modelu

- parametry, ktere urcuji tvar nebo komplexitu modelu: kriterium (gini/entropy), min_samples_split, max_depth, min_ig, ...

Predikce LR

Hledani vektoru koeficientu

Filtracni metody

- vyhodit priznaky, ktere maji prilis nizky rozptyl a jsou tedy temer konstantni

- vyhodit priznaky, ktere maji prilis chybejicich hodnot

- vyhodit priznaky, ktere spolu hodne koreluji a jsou tedy redundantni

- vyhodit priznaky, ktere maji nizkou korelaci s vysvetlovanou promennou (v pripade linearniho modelu!)

- u binarnich priznaku muzeme rozdelit vysvetlovanou promennou na 2 skupiny a udelat test hypotezy o rovnosti strednich hodnot - pokud vyjde stejna hodnota, muzeme tento priznak vyhodit

Obalove metody

- cilem je vybrat podmnozinu priznaku, pro kterou je vykonnost modelu co nejvetsi - to muze byt benefit, ale hrozi preuceni!

- velka vypocetni narocnost - i jen naivni vyber

modelu, kde v kazdem chybi

modelu, kde v kazdem chybi  priznak, znamena

priznak, znamena  -krat vetsi vypocetni narocnost

-krat vetsi vypocetni narocnost

Obecne veci ke strojovemu uceni

- snaha predikovat vysvetlovanou promennou na zaklade vstupnich dat

- pri trenovani se data typicky deli na trenovaci, validacni a testovaci

- trenovaci - slouzi k trenovani modelu, kterych je typicky spousta podle ruznych kombinaci hyperparametru

- validacni - slouzi k vybrani nejlepsiho z modelu, na nichz se trenovala data

- testovaci - slouzi k predikci presnosti na novych datech

- trenovaci, validacni a testovaci data by mela byt zcela nezavisla - nejprve data oddelit na 3 separatni mnoziny (typicky treba 60:20:20) a pak az provest trenovani a vyber modelu a odhad presnosti na novych datech

- smi se napr. doplnovat chybejici hodnoty medianem/prumerem z trenovacich dat, ale v zadnem pripade se to nesmi prumerovat s validacnimi nebo testovacimi!

- preuceni - vlastnost modelu, ktery se prilis soustredi na statisticky nevyznamne vychylky/anomalie v datech, kde by jinak pravdepodobne jina podobna data nemela stejnou hodnotu vysvetlovane promenne s tak optimistickou pravdepodobnosti

Regresni strom

Lasso

Minimalizace RSS: Derivovani RSS

Merged prednasky

prednasky-merged.pdf

prednasky-merged.pdf

Rozhodovaci stromy obecne

Vyhody:

- nenarocnost na pripravu dat: poradi si s kategorickymi daty i chybejicimi hodnotami

- jsou jednoduche, srozumitelne, uceni je relativne rychle a predikce taky

- jsou jednoduse interpretovatelne (proc udelaly nejaka rozhodnuti

Nevyhody:

- i drobna zmena v trenovacich datech muze znamenat velkou zmenu ve strukture stromu

- vetsina implementaci podporuje pouze binarni stromy

- najit optimalni strom je NP-uplny problem

- je snadne rozhodovaci strom preucit

Parcialni derivace, gradient, Hessova matice

Postacujici podminka pro existenci lokalniho extremu

Prepis datasetu do maticoveho zapisu

Vyhody, nevyhody, tipy a rady

- je vhodne volit rozumne

, aby se dal delat rozumny odhad a zabranilo se sumu a preuceni

, aby se dal delat rozumny odhad a zabranilo se sumu a preuceni - prilis vysoke

muze na druhou stranu zpusobit, ze se koukame na prilis mnoho bodu v datasetu, ktere uz tim padem vlastne nejsou az tak blizko bodu, ktery predikujeme

muze na druhou stranu zpusobit, ze se koukame na prilis mnoho bodu v datasetu, ktere uz tim padem vlastne nejsou az tak blizko bodu, ktery predikujeme - prokleti dimenzionality - pro vyssi dimenzi muze mit (zejmena) euklidovska metrika velice male odchylky pri zmene jednoho treba i dost vyznamneho priznaku - ztrati se v odmocnine mezi ostatnimi cleny, ktere v souctu muzou byt mnohem vyznamnejsi

- take s vyssi dimenzi podstatne roste (mame-li interval

) delka intervalu, pokud bychom udelali dokonalou krychli, aby zabirala rekneme

) delka intervalu, pokud bychom udelali dokonalou krychli, aby zabirala rekneme  celkoveho objemu:

celkoveho objemu:

- pro

je to

je to  , pro

, pro  je to

je to ![\sqrt[2]{0.1} = 0.316](data:image/svg+xml;base64,PHN2ZyB4bWxuczp4bGluaz0iaHR0cDovL3d3dy53My5vcmcvMTk5OS94bGluayIgd2lkdGg9IjEzLjE3N2V4IiBoZWlnaHQ9IjMuNTA5ZXgiIHN0eWxlPSJ2ZXJ0aWNhbC1hbGlnbjogLTAuODM4ZXg7IiB2aWV3Qm94PSIwIC0xMTUwLjEgNTY3My42IDE1MTAuOSIgcm9sZT0iaW1nIiBmb2N1c2FibGU9ImZhbHNlIiB4bWxucz0iaHR0cDovL3d3dy53My5vcmcvMjAwMC9zdmciPgo8ZGVmcz4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtU1RJWFdFQk1BSU4tMzAiIGQ9Ik00NzYgMzMwYzAgLTE3MiAtNjMgLTM0NCAtMjI2IC0zNDRjLTE3MSAwIC0yMjYgMTg2IC0yMjYgMzUwYzAgMTc3IDY5IDM0MCAyMzAgMzQwYzEzMSAwIDIyMiAtMTQxIDIyMiAtMzQ2ek0zODAgMzI1YzAgMjA4IC00NCAzMjUgLTEzMiAzMjVjLTgzIDAgLTEyOCAtMTE4IC0xMjggLTMyMXM0NCAtMzE3IDEzMCAtMzE3Yzg1IDAgMTMwIDExNSAxMzAgMzEzWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0yRSIgZD0iTTE4MSA0M2MwIC0yOSAtMjYgLTU0IC01NiAtNTRjLTMxIDAgLTU1IDI0IC01NSA1NXMyNSA1NiA1NiA1NmMyOSAwIDU1IC0yNyA1NSAtNTdaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJNQUlOLTMxIiBkPSJNMzk0IDBoLTI3NnYxNWM3NCA0IDk1IDI1IDk1IDgwdjQ0OWMwIDM0IC05IDQ5IC0zMCA0OWMtMTAgMCAtMjcgLTUgLTQ1IC0xMmwtMjcgLTEwdjE0bDE3OSA5MWw5IC0zdi01OTdjMCAtNDMgMjAgLTYxIDk1IC02MXYtMTVaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJNQUlOLTIyMUEiIGQ9Ik05NjMgOTczbC00NzggLTEyMzJoLTMybC0yMDIgNTMwYy0xNyA0NSAtMzcgNTkgLTYyIDU5Yy0xNyAwIC00MyAtMTEgLTY1IC0zMWwtMTIgMjBsMTU2IDEyNGgxOWwyMDQgLTUzNmg0bDQxNCAxMDY2aDU0WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0zMiIgZD0iTTQ3NCAxMzdsLTU0IC0xMzdoLTM5MXYxMmwxNzggMTg5Yzk0IDk5IDEzMCAxNzUgMTMwIDI2MGMwIDkxIC01NCAxNDEgLTEzOSAxNDFjLTcyIDAgLTEwNyAtMzIgLTE0NyAtMTMwbC0yMSA1YzIxIDExNyA4NSAxOTkgMjA4IDE5OWMxMTMgMCAxODUgLTc3IDE4NSAtMTc2YzAgLTc5IC0zOSAtMTU0IC0xMjggLTI0OGwtMTY1IC0xNzZoMjM0YzQyIDAgNjMgMTEgOTYgNjdaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJNQUlOLTNEIiBkPSJNNjM3IDMyMGgtNTg5djY2aDU4OXYtNjZ6TTYzNyAxMjBoLTU4OXY2Nmg1ODl2LTY2WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0zMyIgZD0iTTYxIDUxMGwtMTYgNGMyOSA5NSA5MiAxNjIgMTk2IDE2MmM5MyAwIDE1NiAtNTUgMTU2IC0xMzdjMCAtNDggLTI2IC05OCAtOTMgLTEzOGM0NCAtMTkgNjIgLTMxIDgzIC01M2MyOCAtMzEgNDQgLTc3IDQ0IC0xMjljMCAtNTMgLTE3IC0xMDIgLTQ2IC0xNDBjLTQ4IC02NCAtMTQzIC05MyAtMjMyIC05M2MtNzMgMCAtMTEyIDIxIC0xMTIgNTdjMCAyMSAxOCAzNiA0MSAzNmMxNyAwIDMzIC02IDYxIC0yNmMzNyAtMjYgNTggLTMxIDg2IC0zMSBjNzQgMCAxMzAgNjggMTMwIDE1M2MwIDc2IC0zNSAxMjUgLTEwNCAxNDVjLTIyIDcgLTQ1IDEwIC0xMDIgMTB2MTRjMzggMTMgNjQgMjQgODQgMzZjNDkgMjggODEgNzMgODEgMTM0YzAgNjggLTQyIDEwMiAtMTA4IDEwMmMtNjIgMCAtMTA4IC0zMiAtMTQ5IC0xMDZaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJNQUlOLTM2IiBkPSJNNDQ2IDY4NGwyIC0xNmMtMTU3IC0yNiAtMjY5IC0xMzQgLTI5NiAtMjg1YzQ5IDM4IDgzIDQ1IDEyNyA0NWMxMTcgMCAxODkgLTgwIDE4OSAtMjA5YzAgLTY0IC0xOCAtMTIwIC01MSAtMTYwYy0zNyAtNDYgLTkzIC03MyAtMTU5IC03M2MtNzkgMCAtMTQyIDM3IC0xNzcgMTAxYy0yOCA1MSAtNDcgMTIyIC00NyAxOTJjMCAxMDggMzggMjAzIDEwOSAyNzZjODYgOTAgMTY1IDExNCAzMDMgMTI5ek0zNzggMTg4IGMwIDEyOCAtNDIgMTk0IC0xMzUgMTk0Yy01NyAwIC0xMTYgLTI0IC0xMTYgLTExNmMwIC0xNTIgNDggLTI1MiAxNDIgLTI1MmM3MiAwIDEwOSA3MiAxMDkgMTc0WiI+PC9wYXRoPgo8L2RlZnM+CjxnIHN0cm9rZT0iY3VycmVudENvbG9yIiBmaWxsPSJjdXJyZW50Q29sb3IiIHN0cm9rZS13aWR0aD0iMCIgdHJhbnNmb3JtPSJtYXRyaXgoMSAwIDAgLTEgMCAwKSI+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC41NzQpIiB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMzIiIHg9IjU3NiIgeT0iODE5Ij48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTIyMUEiIHg9IjAiIHk9Ii0yMCI+PC91c2U+CjxyZWN0IHN0cm9rZT0ibm9uZSIgd2lkdGg9IjEyNTEiIGhlaWdodD0iNjAiIHg9IjkyOCIgeT0iODk0Ij48L3JlY3Q+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDkyOCwwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0yRSIgeD0iNTAwIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTMxIiB4PSI3NTEiIHk9IjAiPjwvdXNlPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zRCIgeD0iMjQ1NyIgeT0iMCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDM0MjEsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMzAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMkUiIHg9IjUwMCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zMyIgeD0iNzUxIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTMxIiB4PSIxMjUxIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTM2IiB4PSIxNzUyIiB5PSIwIj48L3VzZT4KPC9nPgo8L2c+Cjwvc3ZnPg==) , pro

, pro  je to

je to ![\sqrt[3]{0.464}](data:image/svg+xml;base64,PHN2ZyB4bWxuczp4bGluaz0iaHR0cDovL3d3dy53My5vcmcvMTk5OS94bGluayIgd2lkdGg9IjcuMzg4ZXgiIGhlaWdodD0iMy41MDlleCIgc3R5bGU9InZlcnRpY2FsLWFsaWduOiAtMC44MzhleDsiIHZpZXdCb3g9IjAgLTExNTAuMSAzMTgxIDE1MTAuOSIgcm9sZT0iaW1nIiBmb2N1c2FibGU9ImZhbHNlIiB4bWxucz0iaHR0cDovL3d3dy53My5vcmcvMjAwMC9zdmciPgo8ZGVmcz4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtU1RJWFdFQk1BSU4tMzAiIGQ9Ik00NzYgMzMwYzAgLTE3MiAtNjMgLTM0NCAtMjI2IC0zNDRjLTE3MSAwIC0yMjYgMTg2IC0yMjYgMzUwYzAgMTc3IDY5IDM0MCAyMzAgMzQwYzEzMSAwIDIyMiAtMTQxIDIyMiAtMzQ2ek0zODAgMzI1YzAgMjA4IC00NCAzMjUgLTEzMiAzMjVjLTgzIDAgLTEyOCAtMTE4IC0xMjggLTMyMXM0NCAtMzE3IDEzMCAtMzE3Yzg1IDAgMTMwIDExNSAxMzAgMzEzWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0yRSIgZD0iTTE4MSA0M2MwIC0yOSAtMjYgLTU0IC01NiAtNTRjLTMxIDAgLTU1IDI0IC01NSA1NXMyNSA1NiA1NiA1NmMyOSAwIDU1IC0yNyA1NSAtNTdaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJNQUlOLTM0IiBkPSJNNDczIDE2N2gtMTAzdi0xNjdoLTc4djE2N2gtMjgwdjY0bDMxNCA0NDVoNDR2LTQ0NWgxMDN2LTY0ek0yOTIgMjMxdjM0M2wtMjQwIC0zNDNoMjQwWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0zNiIgZD0iTTQ0NiA2ODRsMiAtMTZjLTE1NyAtMjYgLTI2OSAtMTM0IC0yOTYgLTI4NWM0OSAzOCA4MyA0NSAxMjcgNDVjMTE3IDAgMTg5IC04MCAxODkgLTIwOWMwIC02NCAtMTggLTEyMCAtNTEgLTE2MGMtMzcgLTQ2IC05MyAtNzMgLTE1OSAtNzNjLTc5IDAgLTE0MiAzNyAtMTc3IDEwMWMtMjggNTEgLTQ3IDEyMiAtNDcgMTkyYzAgMTA4IDM4IDIwMyAxMDkgMjc2Yzg2IDkwIDE2NSAxMTQgMzAzIDEyOXpNMzc4IDE4OCBjMCAxMjggLTQyIDE5NCAtMTM1IDE5NGMtNTcgMCAtMTE2IC0yNCAtMTE2IC0xMTZjMCAtMTUyIDQ4IC0yNTIgMTQyIC0yNTJjNzIgMCAxMDkgNzIgMTA5IDE3NFoiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtU1RJWFdFQk1BSU4tMjIxQSIgZD0iTTk2MyA5NzNsLTQ3OCAtMTIzMmgtMzJsLTIwMiA1MzBjLTE3IDQ1IC0zNyA1OSAtNjIgNTljLTE3IDAgLTQzIC0xMSAtNjUgLTMxbC0xMiAyMGwxNTYgMTI0aDE5bDIwNCAtNTM2aDRsNDE0IDEwNjZoNTRaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJNQUlOLTMzIiBkPSJNNjEgNTEwbC0xNiA0YzI5IDk1IDkyIDE2MiAxOTYgMTYyYzkzIDAgMTU2IC01NSAxNTYgLTEzN2MwIC00OCAtMjYgLTk4IC05MyAtMTM4YzQ0IC0xOSA2MiAtMzEgODMgLTUzYzI4IC0zMSA0NCAtNzcgNDQgLTEyOWMwIC01MyAtMTcgLTEwMiAtNDYgLTE0MGMtNDggLTY0IC0xNDMgLTkzIC0yMzIgLTkzYy03MyAwIC0xMTIgMjEgLTExMiA1N2MwIDIxIDE4IDM2IDQxIDM2YzE3IDAgMzMgLTYgNjEgLTI2YzM3IC0yNiA1OCAtMzEgODYgLTMxIGM3NCAwIDEzMCA2OCAxMzAgMTUzYzAgNzYgLTM1IDEyNSAtMTA0IDE0NWMtMjIgNyAtNDUgMTAgLTEwMiAxMHYxNGMzOCAxMyA2NCAyNCA4NCAzNmM0OSAyOCA4MSA3MyA4MSAxMzRjMCA2OCAtNDIgMTAyIC0xMDggMTAyYy02MiAwIC0xMDggLTMyIC0xNDkgLTEwNloiPjwvcGF0aD4KPC9kZWZzPgo8ZyBzdHJva2U9ImN1cnJlbnRDb2xvciIgZmlsbD0iY3VycmVudENvbG9yIiBzdHJva2Utd2lkdGg9IjAiIHRyYW5zZm9ybT0ibWF0cml4KDEgMCAwIC0xIDAgMCkiPgogPHVzZSB0cmFuc2Zvcm09InNjYWxlKDAuNTc0KSIgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTMzIiB4PSI2MTkiIHk9IjgyNiI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0yMjFBIiB4PSIwIiB5PSItMTYiPjwvdXNlPgo8cmVjdCBzdHJva2U9Im5vbmUiIHdpZHRoPSIyMjUyIiBoZWlnaHQ9IjYwIiB4PSI5MjgiIHk9Ijg5OCI+PC9yZWN0Pgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg5MjgsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMzAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMkUiIHg9IjUwMCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zNCIgeD0iNzUxIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTM2IiB4PSIxMjUxIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTM0IiB4PSIxNzUyIiB5PSIwIj48L3VzZT4KPC9nPgo8L2c+Cjwvc3ZnPg==) , pro

, pro  je to

je to ![\sqrt[50]{0.1} = 0.955](data:image/svg+xml;base64,PHN2ZyB4bWxuczp4bGluaz0iaHR0cDovL3d3dy53My5vcmcvMTk5OS94bGluayIgd2lkdGg9IjEzLjE3N2V4IiBoZWlnaHQ9IjMuNTA5ZXgiIHN0eWxlPSJ2ZXJ0aWNhbC1hbGlnbjogLTAuODM4ZXg7IiB2aWV3Qm94PSIwIC0xMTUwLjEgNTY3My42IDE1MTAuOSIgcm9sZT0iaW1nIiBmb2N1c2FibGU9ImZhbHNlIiB4bWxucz0iaHR0cDovL3d3dy53My5vcmcvMjAwMC9zdmciPgo8ZGVmcz4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtU1RJWFdFQk1BSU4tMzAiIGQ9Ik00NzYgMzMwYzAgLTE3MiAtNjMgLTM0NCAtMjI2IC0zNDRjLTE3MSAwIC0yMjYgMTg2IC0yMjYgMzUwYzAgMTc3IDY5IDM0MCAyMzAgMzQwYzEzMSAwIDIyMiAtMTQxIDIyMiAtMzQ2ek0zODAgMzI1YzAgMjA4IC00NCAzMjUgLTEzMiAzMjVjLTgzIDAgLTEyOCAtMTE4IC0xMjggLTMyMXM0NCAtMzE3IDEzMCAtMzE3Yzg1IDAgMTMwIDExNSAxMzAgMzEzWiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0yRSIgZD0iTTE4MSA0M2MwIC0yOSAtMjYgLTU0IC01NiAtNTRjLTMxIDAgLTU1IDI0IC01NSA1NXMyNSA1NiA1NiA1NmMyOSAwIDU1IC0yNyA1NSAtNTdaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJNQUlOLTMxIiBkPSJNMzk0IDBoLTI3NnYxNWM3NCA0IDk1IDI1IDk1IDgwdjQ0OWMwIDM0IC05IDQ5IC0zMCA0OWMtMTAgMCAtMjcgLTUgLTQ1IC0xMmwtMjcgLTEwdjE0bDE3OSA5MWw5IC0zdi01OTdjMCAtNDMgMjAgLTYxIDk1IC02MXYtMTVaIj48L3BhdGg+CjxwYXRoIHN0cm9rZS13aWR0aD0iMSIgaWQ9IkUxLVNUSVhXRUJNQUlOLTIyMUEiIGQ9Ik05NjMgOTczbC00NzggLTEyMzJoLTMybC0yMDIgNTMwYy0xNyA0NSAtMzcgNTkgLTYyIDU5Yy0xNyAwIC00MyAtMTEgLTY1IC0zMWwtMTIgMjBsMTU2IDEyNGgxOWwyMDQgLTUzNmg0bDQxNCAxMDY2aDU0WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0zNSIgZD0iTTQzOCA2ODFsLTM2IC04NWMtMyAtNyAtMTEgLTEzIC0yNyAtMTNoLTE5NGwtNDAgLTg1YzE0MyAtMjcgMTkzIC00OSAyNTAgLTEyOGMyNiAtMzYgMzUgLTc0IDM1IC0xMjdjMCAtOTYgLTMwIC0xNTggLTk4IC0yMDhjLTQ3IC0zNCAtMTAyIC00OSAtMTcwIC00OWMtNzUgMCAtMTI3IDI0IC0xMjcgNjJjMCAyNSAxNyAzOCA0NSAzOGMyMyAwIDQyIC01IDc0IC0zMWMyOCAtMjMgNTEgLTMyIDcxIC0zMmM3MCAwIDEzNSA4MyAxMzUgMTY5IGMwIDY0IC0yMiAxMTQgLTY3IDE1MGMtNDcgMzggLTExNyA3MCAtMjEzIDcwYy05IDAgLTEyIDIgLTEyIDhjMCAyIDEgNSAxIDVsMTA5IDIzN2gyMDdjMjMgMCAzMiA1IDQ4IDI2WiI+PC9wYXRoPgo8cGF0aCBzdHJva2Utd2lkdGg9IjEiIGlkPSJFMS1TVElYV0VCTUFJTi0zRCIgZD0iTTYzNyAzMjBoLTU4OXY2Nmg1ODl2LTY2ek02MzcgMTIwaC01ODl2NjZoNTg5di02NloiPjwvcGF0aD4KPHBhdGggc3Ryb2tlLXdpZHRoPSIxIiBpZD0iRTEtU1RJWFdFQk1BSU4tMzkiIGQ9Ik01OSAtMjJsLTMgMjBjMTUyIDI3IDI2NCAxMzIgMzA0IDI5NmMtNDMgLTQyIC05MSAtNTcgLTE1MCAtNTdjLTEwOCAwIC0xODAgODEgLTE4MCAyMDNjMCAxMzUgODkgMjM2IDIwOCAyMzZjNjQgMCAxMTggLTI4IDE1NyAtNzZjNDAgLTUwIDY0IC0xMjIgNjQgLTIwNmMwIC0xMTUgLTQwIC0yMjQgLTEyMCAtMjk3Yy04NSAtNzcgLTE1MCAtMTAxIC0yODAgLTExOXpNMzYyIDM1NXYzOWMwIDE2OCAtNDUgMjU0IC0xMzIgMjU0IGMtMzAgMCAtNTYgLTEyIC03MyAtMzRjLTIwIC0yNyAtMzUgLTg2IC0zNSAtMTQwYzAgLTExOSA0OCAtMTk0IDEyMyAtMTk0YzQ0IDAgMTE3IDIyIDExNyA3NVoiPjwvcGF0aD4KPC9kZWZzPgo8ZyBzdHJva2U9ImN1cnJlbnRDb2xvciIgZmlsbD0iY3VycmVudENvbG9yIiBzdHJva2Utd2lkdGg9IjAiIHRyYW5zZm9ybT0ibWF0cml4KDEgMCAwIC0xIDAgMCkiPgo8ZyB0cmFuc2Zvcm09InRyYW5zbGF0ZSg0Miw0NzApIj4KIDx1c2UgdHJhbnNmb3JtPSJzY2FsZSgwLjU3NCkiIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zNSI+PC91c2U+CiA8dXNlIHRyYW5zZm9ybT0ic2NhbGUoMC41NzQpIiB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMzAiIHg9IjUwMCIgeT0iMCI+PC91c2U+CjwvZz4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTIyMUEiIHg9IjAiIHk9Ii0yMCI+PC91c2U+CjxyZWN0IHN0cm9rZT0ibm9uZSIgd2lkdGg9IjEyNTEiIGhlaWdodD0iNjAiIHg9IjkyOCIgeT0iODk0Ij48L3JlY3Q+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDkyOCwwKSI+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0yRSIgeD0iNTAwIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTMxIiB4PSI3NTEiIHk9IjAiPjwvdXNlPgo8L2c+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zRCIgeD0iMjQ1NyIgeT0iMCI+PC91c2U+CjxnIHRyYW5zZm9ybT0idHJhbnNsYXRlKDM0MjEsMCkiPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMzAiPjwvdXNlPgogPHVzZSB4bGluazpocmVmPSIjRTEtU1RJWFdFQk1BSU4tMkUiIHg9IjUwMCIgeT0iMCI+PC91c2U+CiA8dXNlIHhsaW5rOmhyZWY9IiNFMS1TVElYV0VCTUFJTi0zOSIgeD0iNzUxIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTM1IiB4PSIxMjUxIiB5PSIwIj48L3VzZT4KIDx1c2UgeGxpbms6aHJlZj0iI0UxLVNUSVhXRUJNQUlOLTM1IiB4PSIxNzUyIiB5PSIwIj48L3VzZT4KPC9nPgo8L2c+Cjwvc3ZnPg==) atd.

atd.

Forward & backward selection

Forward selection:

- Zaciname s

, vezmeme po jednom z priznaku

, vezmeme po jednom z priznaku  , natrenujeme pro ruzne mnoziny priznaku

, natrenujeme pro ruzne mnoziny priznaku  a vratime

a vratime  , jehoz pridani zpusobilo nejlepsi validacni presnost

, jehoz pridani zpusobilo nejlepsi validacni presnost - dokud jsme si polepsili (pripadne o nejaky threshold) nebo jsme neporusili threshold pro max. pocet priznaku, polozime

a opakujeme predchozi bod s mnozinou jeste nevybranych priznaku

a opakujeme predchozi bod s mnozinou jeste nevybranych priznaku - slozitost:

krat rychlost natrenovani jednoho modelu

krat rychlost natrenovani jednoho modelu

Backward selection:

- funguje uplne stejne, jen zacne se vsemi priznaky a po jednom odebira, dokud nebudeme mit pozadovany pocet a stale doslo ke zlepseni (pripadne pro nejaky threshold)

Rekurzivni odebirani priznaku

- model se natrenuje jen jednou a ohodnoti jednotlive priznaky (musi toho byt schopen)

- napr. regrese - maji koeficienty - blizko nule znamena nevyznamny, atd.

- nasledne se za linear ku poctu priznaku vyhazou priznaky

tvrzeni o geometrickem stredu

Tvrzeni:

- Pro konecnou mnozinu

plati

plati

- kde

je geometricky stred (centroid) mnoziny

je geometricky stred (centroid) mnoziny  - tedy ze

- tedy ze  je optimalni

je optimalni

- tedy soucet vzdalenosti od bodu je nejmensi, pokud je dany bod prumerem dat

- presne takhle funguje optimum pro MSE

Dukaz:

Norma

Metrika

Metoda nejblizsich sousedu (kNN)

- spoleha na to, ze datove body, ktere maji stejjne nebo (ciselne) podobne parametry, maji vetsi sanci na stejnou binarni predikci pripadne podobnou hodnotu spojite vysvetlovane promenne

- hyperparametr

- pocet sousedu, metrika

- pocet sousedu, metrika

- pomerne dobre vysledky je obcas mozne dosahnout i s nejakou slabsi metrikou, ktera nesplnuje vsechny 3 axiomy (hlavne trojuhelnikovou nerovnost), ale ne vzdy - navic je pak predikce pomalejsi, protoze bez teto vlastnosti data nejde moc chunkovat

- je nutne data normalizovat

- standard scaler - naskaluje data, aby byla stredni hodnota 0 a rozptyl

- min-max scaler - nejmensi hodnotu zmeni na nulu, nejvetsi na 1 a mezi nimi udela nejakou interpolaci (typicky linearni)

- proces trenovani neni - predikuje se primo na trenovacich datech

- pro kazdy datovy bod se vybere

nejblizsich sousedu podle metriky

nejblizsich sousedu podle metriky  a predikuje se v pripade binarni klasifikace majoritou, v pripade regrese prumerem

a predikuje se v pripade binarni klasifikace majoritou, v pripade regrese prumerem

Modely bazovych funkci

- linearni model:

- je ale mozne vytvorit ruzne funkce

, ktere berou aktualni priznaky a vytvorit z nich nove priznaky

, ktere berou aktualni priznaky a vytvorit z nich nove priznaky - s temito priznaky pak natrenujeme model

- vetsinou se pouziva hrebenova regrese, protoze priznaky spis jenom pridavame, nez abychom nahrazovali jiz existujici

Predikce

- predikce v bode

:

:

Geometricka interpretace

Pokracovani: Gradient, normalni rovnice, Hessova matice

Nesupervizovane uceni

- data nemame nijak oznacena, nemame, co predikovat, chceme porozumet strukture

- tzn. analyza nejake stabilni struktury datasetu - kde se data vyskytuji, tzn. shlukovani

- uvazme situaci, kdy nase -data obsahuji

priznaku a oznacme

priznaku a oznacme  prostor, ve kterem se nachazeji mozne vysledky

prostor, ve kterem se nachazeji mozne vysledky

- pro binarni priznaky volime

- pro

spojitych priznaku typicky volime

spojitych priznaku typicky volime

- z pohledu teorie pravdepodobnosti a statistiky chapeme pozorovana data jako realizace nahodneho vektoru

- porozumeni vnitrni strukture znamena porozumeni rozdeleni

0 chceme ziskat odhad pravdepodobnosti

0 chceme ziskat odhad pravdepodobnosti  pro kazdou (rozumnou) podmnozinu

pro kazdou (rozumnou) podmnozinu

Evaluace modelu

Krizova validace

1. bokem si oddelime testovaci data

2. zbytek trenovacich dat  si rozdelime na

si rozdelime na  podobne velkych

podobne velkych

3. pro kazdou kombinaci hyperparametru  :

:

4. for J in 1..k:

5. natrenuj model na datech  s hyperparametry

s hyperparametry

6. na mnozine  odhadni chybu jako

odhadni chybu jako

7. spocitej cross-validacni chybu pro  :

:

8. vrat kombinaci hyperparametru  s nejlepsim

s nejlepsim

- typicke volby jsou

- muze byt extremne vypocetne narocna

- vhodna, pokud je malo dat

- pri extremne malem mnozstvi dat lze odhadnout chybu pomoci oddelovani testovaci mnoziny v dalsim vnejsim for cyklu

Shlukovani jako optimalizacni uloha

Shlukovani

- vstupy:

- metricky prostor

s metrikou

s metrikou

- mnozina dat

- obvykle i pozadovany pocet shluku

- vystupy:

Konvergence algoritmus k-means

Tvrzeni:

- algoritmus k-means v zadne jeho iteraci nezvetsi hodnotu ucelove funkce

Dukaz:

problem kolinearity

- existuji linearni kombinace sloupcu, ktere daji temer nulkove vektory, zatimco jine linearni kombinace vraci mnohem vetsi vektory:

pro nejake

pro nejake

- existuji smery, kde ma predikce obrovsky rozptyl a predikce budou dost skakat

Co s tim?

- prigenerovat data (muze a nemusi pomoct)

- zkusit se zbavit problematickych priznaku

- zmenit, co chceme minimalizovat: pridat regularizacni clen → hrebenova regrese

ROC, AUC

Pokracovani

- Implementace ve Scikitu vraci vektor

, ktery resi normalni rovnici a zaroven ma co nejmensi normu. Proc to je dobre?

, ktery resi normalni rovnici a zaroven ma co nejmensi normu. Proc to je dobre? - predpokladejme

, tedy rovnice je ve tvaru

, tedy rovnice je ve tvaru  , oznacme

, oznacme  , zaroven tedy

, zaroven tedy

- kdybychom meli predikovat hodnotu pro datovy bod, kde

(napr.

(napr.  a

a  ma velkou normu (treba

ma velkou normu (treba  -krat), predikce by se zvetsila o dost vic, nez jak by se zmenila pro mensi

-krat), predikce by se zvetsila o dost vic, nez jak by se zmenila pro mensi

Jednoznacnost reseni

Algoritmus k-means

- problem nalezeni globalniho minima uvedene ucelove funkce je NP-tezky

- algoritmus k-means: iterativni algoritmus, ktery konverguje k nejakemu jejimu lokalnimu minimu:

Algoritmus:

- Zvolme si

stredovych bodu

stredovych bodu

- Kazdy bod

prirad do shluku se stredovym bodem

prirad do shluku se stredovym bodem  takovym, ze

takovym, ze  je minimalni

je minimalni  : prepocitej stredovy bod

: prepocitej stredovy bod  jako geometricky stred prislusneho shluku

jako geometricky stred prislusneho shluku- Pokud se shluky nejak zmenily a nebylo dosazeno pripadneho zastavovaciho kriteria, vrat se na bod (2.)

Jak vybrat pocatecni stredove body?

- typicky nahodnym vyberem z dat, ktere jsou idealne nejak rozumne od sebe

- typicky se algoritmus spusti vickrat a vezme se to shlukovani, kde ma ucelova funkce nejmensi hodnotu

Jak zvolit  ?

?

- lze ocekavat, ze pokud "podstrelime" idealni pocet shluku, ucelova funkce se o dost snizi, tedy muzeme pro

iterovat, dokud tento graf od

iterovat, dokud tento graf od  bude rozumne klesat

bude rozumne klesat - tato metoda muze fungovat, ale casto je pomerne nepouzitelna

Evaluace klasifikacniho modelu

Evaluacni miry podle presnosti a ocekavaneho vysledku

- true positive rate/sensitiva/recall/hit rate - spravne 1 (spravne detekuji nemoc)

- false positive rate/false alarm rate/type 1 error rate - v realite 0, ale predikce byla 1 (nekdo zdravy dostane pozitivni vysledek na test)

- false negative rate/miss rate/type 2 error rate - v realite 1, ale predikce byla 0 (nepozname, ze je nekdo nemocny)

- true negative rate/specificita/selektivita - spravne 0 (spravne necham zdraveho cloveka byt)

Evaluacni miry:

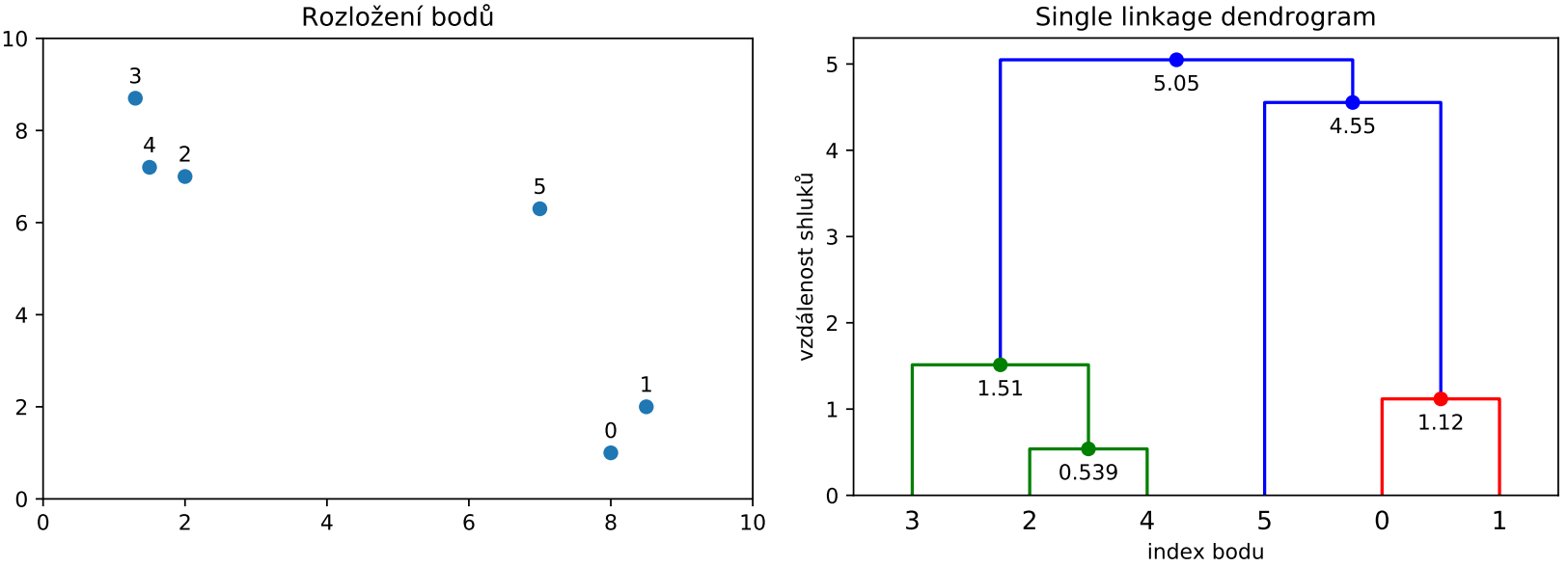

Hierarchicke shlukovani

- na zacatku uvazujeme kazdy bod jako jednotlivy shluk

- pokud existuji alespon 2 shluky, najdeme 2 shluky, ktere jsou k sobe nejbliz

- tyto 2 shluky spoj do noveho shluku a pokracuj na krok (2.)

Poznamky:

- zastavovaci kriterium: pocet shluku

- nebo threshold, ktere shluky jeste spojit

- zavisi na definici vzdalenosti shluku

Hrebenova regrese

- pridani penalizacniho clenu umerneho kvadratu normy koeficientu

s vynechanim interceptu:

s vynechanim interceptu:

- pro

mame linearni regresi

mame linearni regresi - pro

cilime na nizsi normu vektoru

cilime na nizsi normu vektoru Zavedme matici

- potom

- gradient:

- normalni rovnice:

- Hessova matice

Jednotlive metody

- metoda nejblizsiho souseda (single linkage): minimum vzdalenosti bodu z jednotlivych shluku - ma tendenci delat dlouhe retezy

- metoda nejvzdalenejsiho souseda (complete linkage): maximum vzdalenosti bodu z jednotlivych shluku - ma tendenci delat kompaktni shluky

- parova vzdalenost (average linkage): prumer vzdalenosti mezi kazdou dvojici bodu z ruznych shluku

- Wardova metoda: pro kazdou dvojici shluku spocita rozptyl obou shluku vuci prumeru a kdyby doslo ke sjednoceni, cili na maly rozdil rozptylu po sjednoceni, vyuziva euklidovskou vzdalenost

Zkoumame regularitu

Evaluace pomoci Silhouette skore

- uvazujme shlukovani

na metrickem prostoru

na metrickem prostoru  s metrikou

s metrikou  a pro libovolny bod

a pro libovolny bod  oznacme

oznacme  index shluku, do ktereho

index shluku, do ktereho  patri, tj.

patri, tj.

- pro bod

ted muzeme:

ted muzeme:

Pokracovani

Predikce

Kdy reseni neni jednoznacne

Ensemble metody

DBSCAN - definice

- mejme metricky prostor

s metrikou

s metrikou  , ze ktereho pochazi dataset

, ze ktereho pochazi dataset  a parametry

a parametry  a

a

- definujme

-okoli bodu

-okoli bodu  v

v  jako mnozinu

jako mnozinu

- bod

je klicovy bod, jestlize v jeho

je klicovy bod, jestlize v jeho  -okoli v

-okoli v  je alespon

je alespon  bodu, tzn.

bodu, tzn.

- bod

je primo dosazitelny z bodu

je primo dosazitelny z bodu  , jestlize

, jestlize  je klicovy bod a

je klicovy bod a  , tj.

, tj.  ma alespon

ma alespon  bodu v okoli a

bodu v okoli a  je jeden z nich

je jeden z nich - pro dvojici klicovych bodu je relace prime dosazitelnosti symetricka, ale pro tzv. okrajovy bod symetricka neni (takovy bod, ktery neni klicovy, ale je dosazitelny z klicoveho bodu)

- bod

je dosazitelny z bodu

je dosazitelny z bodu  , pokud v grafu relace prime dosazitelnosti existuje orientovana

, pokud v grafu relace prime dosazitelnosti existuje orientovana  -

- -cesta

-cesta - bod

je spojeny s bodem

je spojeny s bodem  , jestlize existuje klicovy bod

, jestlize existuje klicovy bod  takovy, ze

takovy, ze  i

i  jsou dosazitelne z bodu

jsou dosazitelne z bodu  (tzn. existuje orientovana

(tzn. existuje orientovana  -

- -cesta a orientovana

-cesta a orientovana  -

- -cesta a orientovana

-cesta a orientovana  -

- -cesta), jde o symetrickou relaci a pro klicove body i tranzitivni

-cesta), jde o symetrickou relaci a pro klicove body i tranzitivni - pro

takove, ze

takove, ze  jsou spojene a

jsou spojene a  je klicovy, pak

je klicovy, pak  je dosazitelny z

je dosazitelny z

- shluk je maximalni mnozina spojenych bodu, formalne shluk

je neprazdna podmnozina

je neprazdna podmnozina  takova, ze

takova, ze

- pro kazde

plati, ze pokud

plati, ze pokud  a

a  je dosazitelny z

je dosazitelny z  , pak

, pak

- pro kazde

je

je  spojeny s

spojeny s  (souvislost)

(souvislost)

Pokracovani

Vazeni datovych bodu

Vazene trenovani:

- dalsi stromy se uci na tom, jak dobre/spatne predikovaly ty predchozi

- pri uceni stromu se vahy projevi v kroku, kde se pocita informacni zisk (entropie)

- pro uzel

se napr. pro vypocet entropie

se napr. pro vypocet entropie  pouzije odhad pravdepodobnosti tridy 1 urceny souctem vah bodu ve tride 1, ktere spadaji do

pouzije odhad pravdepodobnosti tridy 1 urceny souctem vah bodu ve tride 1, ktere spadaji do  , podeleny souctem vah vsech bodu v

, podeleny souctem vah vsech bodu v  , lze delat podobne i pro regresni ulohu

, lze delat podobne i pro regresni ulohu - pokud mame napr. datove body s vahami

, pak soucet vah pro

, pak soucet vah pro  je

je  , soucet vsech vah je

, soucet vsech vah je  , tedy pravdepodobnost tridy

, tedy pravdepodobnost tridy  je v tomto pripade

je v tomto pripade

- tedy u vypoctu entropie se

(

( obdobne) spocita jako

obdobne) spocita jako

- strom se (logicky) snazi lepe predikovat body s vetsi vahou, tedy cim dela vetsi chyby, tim je vetsi penalizace, aby se je priste snazil zmensit

Vazena predikce:

- predikuje se

, pokud soucet vah pro

, pokud soucet vah pro  nadpolovicni, nez soucet vsech vah

nadpolovicni, nez soucet vsech vah

Poznamka:

- je vhodne mit "weak learners" - modely, ktere casto delaji chyby, ale spise se nepreuci

- nemusi jit nutne o rozhodovaci strom, dulezite je, aby model podporoval vazeni dat

- redukce vychyleni (bias) - mene systematickych chyb

Pokracovani

- celkova chyba je tedy

(viz nize)

(viz nize) - tedy soucet neodstranitelne chyby, kvadratu vychyleni odhadu a rozptylu odhadu

- rozptyl: jak moc se podle trenovacich dat meni predikce

- vychyleni: systematicke vychyleni

- typicky je jedno zvetsuje, druhe zmensuje, chceme minimalizovat soucet

Trenovani - metoda maximalni verohodnosti

- Oznacme

jako pravdepodobnost, ze datovy bod nabyval hodnoty

jako pravdepodobnost, ze datovy bod nabyval hodnoty  :

:

- Pak oznacme

jako pravdepodobnost, ze datovy bod nabyval hodnoty

jako pravdepodobnost, ze datovy bod nabyval hodnoty  :

:

- Pravdepodobnost, ze

-ty datovy bod tedy skutecne nabyval hodnoty

-ty datovy bod tedy skutecne nabyval hodnoty  (skutecne hodnoty, ktera nastala), se tedy da vypocitat jako

(skutecne hodnoty, ktera nastala), se tedy da vypocitat jako

- Predpokladame, ze jednotlive namerene hodnoty jsou na sobe nezavisle, pak (z PST) vime, ze pravdepodnost, ze vsechny jevy nastaly zaroven, se da spocitat jako soucet jednotlivych pravdepodobnosti. Mame fixni trenovaci data

a muzeme tedy v zavislosti na parametrech

a muzeme tedy v zavislosti na parametrech  tuto pravdepodobnost odhadnout jako

tuto pravdepodobnost odhadnout jako

- Tuto pravdepodobnost chceme maximalizovat.

- Teto metode pouzivane pri trenovani modelu logisticke regrese se rika metoda maximalni verohodnosti: Hledame takovy vektor parametru

, pro ktery je nejvetsi sance, ze trenovaci data nabyvala takovych hodnot, nez pro kterekoliv jine

, pro ktery je nejvetsi sance, ze trenovaci data nabyvala takovych hodnot, nez pro kterekoliv jine  .

. - Hledame tedy globalni maximum teto verohodnostni funkce

Logisticka regrese

- metoda pro klasifikaci, my se omezime na binarni klasifikaci

- budeme urcovat pravdepodobnost prislusnosti k dane tride

- podobne jako u linearni regrese uvazujme linearni zavislost na jednotlivych priznacich, tentokrat na tom ale zavisi tato pravdepodobnost

- oznacme

- stejne jako u linearni regrese nejaky intercept + koeficienty priznaku (tedy vektor

- stejne jako u linearni regrese nejaky intercept + koeficienty priznaku (tedy vektor  )

) - pocitame s tim, ze existuje nejake rozumne rozdeleni roviny na 2 casti (z pohledu vizualizace teto linearni kombinace) s tim, ze cim dal jsme od hranice na jednu stranu, tim vetsi hodnota

a naopak cim dal jsme od hranice na druhou stranu, tim mensi hodnota

a naopak cim dal jsme od hranice na druhou stranu, tim mensi hodnota

- tuto hodnotu

chceme nejak rozumne vmestnat do moznych hodnot

chceme nejak rozumne vmestnat do moznych hodnot  , coz je interval

, coz je interval  , a to tak, aby nepresnost u hodne kladne nebo hodne zaporna hodnota nezmenila fakt, ze ta si je model hodne jisty

, a to tak, aby nepresnost u hodne kladne nebo hodne zaporna hodnota nezmenila fakt, ze ta si je model hodne jisty

bias-variance tradeoff u hrebenove regrese

Dendrogram

- binarni strom, ktery reprezentuje jednotlive kroky shlukovani, pokud algoritmus nema zadany max. pocet shluku

- listy jsou mnoziny s pocatecnimi body

- koren je cely dataset

- jednotlive vrcholy jsou disjunktnim sjednocenim prave dvou vrcholu, a to prave tech, ktere algoritmus sjednotil na tento novy vrchol

- kazdy vrchol, ktery neni list, ma v sobe zaroven ciselnou hodnotu, ktera urcuje vzdalenost tech dvou mnozin vrcholu, ktere byly sjednoceny v tento vrchol

- pokud chceme

shluku, pak dendrogram usekneme pod

shluku, pak dendrogram usekneme pod  -tym nejvyssim vrcholem (pro 1 shluk nic nesekame, pro 2 shluky pod 1., pro 3 shluky pod 2., …) a hrany, ktere toto "useknuti" protne, vedou smerem dolu do prave tech

-tym nejvyssim vrcholem (pro 1 shluk nic nesekame, pro 2 shluky pod 1., pro 3 shluky pod 2., …) a hrany, ktere toto "useknuti" protne, vedou smerem dolu do prave tech  shluku

shluku - zaroven lze nastavit threshold, coz je proste

-souradnice, na niz se seka

-souradnice, na niz se seka - zaroven se da porovnat vysky dvou sousednich vrcholu v ramci osy

, coz znaci, o kolik by se musel zvetsit threshold pro spojeni, aby se spojil ten vyssi z tech vrcholu

, coz znaci, o kolik by se musel zvetsit threshold pro spojeni, aby se spojil ten vyssi z tech vrcholu

Nahodne lesy

- ze vstupniho trenovaciho datasetu

vytvorime

vytvorime  datasetu

datasetu  (obvykle stejne velkych jako

(obvykle stejne velkych jako  ) pomoci metody bootstrap - vyberu s opakovanim

) pomoci metody bootstrap - vyberu s opakovanim - na kazdem datasetu

naucime rozhodovaci strom, typicky vybereme jen nejaky zlomek priznaku:

naucime rozhodovaci strom, typicky vybereme jen nejaky zlomek priznaku:

- pri predikci predikuji pomoci vsech stromu a predikce zprumeruji

- muzu zaroven delat vazeny prumer, jak moc si je dany strom jisty

- hyperparametry: pocet lesu, pomer

, parametry pro stromy, pomer/pocet (predem nahodne vybranych) featur

, parametry pro stromy, pomer/pocet (predem nahodne vybranych) featur - prumeruji se nezavisla data, cimz se redukuje rozptyl

- odolnejsi vuci preucenim

- horsi interpretovatelnost

- pomalejsi na natrenovani

Vztah vychyleni a rozptylu

Pokracovani silhoutte skore

- plati, ze

- pro

:

:

- nikdy nebude

vetsi nez

vetsi nez  ve jmenovateli

ve jmenovateli  : prumerna vzdalenost k jinemu nejblizsimu clusteru je vetsi nez k aktualnimu → GOOD

: prumerna vzdalenost k jinemu nejblizsimu clusteru je vetsi nez k aktualnimu → GOOD

- pro

- nikdy nebude

v abs. hodnote vetsi nez

v abs. hodnote vetsi nez

: prumerna vzdalenost k jinemu nejblizsimu clusteru je mensi nez k aktualnimu (existuje blizsi cluster) → BAD

: prumerna vzdalenost k jinemu nejblizsimu clusteru je mensi nez k aktualnimu (existuje blizsi cluster) → BAD

- pro

:

:

- bod je typicky blizko hranici, napr. okrajovy bod pri DBSCAN

- dobre u k-means a average linkage, u DBSCANu muze byt horsi, pokud jsou tvary hodne rozplacnute

DBSCAN - algoritmus

- Pro zadane

spocitej

spocitej  - okoli kazdeho bodu a identifikuj klicove body

- okoli kazdeho bodu a identifikuj klicove body - Vytvor zarodky shluku: Spoj sousedni (primo dosazitelne) body do shluku

- Pro kazdy bod, ktery neni klicovy: Pridej ho do shluku podle klicoveho bodu v okoli, pokud nejaky existuje, jinak ho pridej mezi sum

Poznamky:

- Pokud ma nejaky okrajovy bod vice klicovych bodu ve svem

-okoli vice ruznych zarodku shluku, spadne do prvniho shluku, ke kteremu se algoritmus dostane

-okoli vice ruznych zarodku shluku, spadne do prvniho shluku, ke kteremu se algoritmus dostane - lze ukazatm ze slozitost je v nejhorsim pripade

, v mnoha realnych situacich se ale realne dostane na

, v mnoha realnych situacich se ale realne dostane na

- hyperparametry:

, kde

, kde  je typicky dulezitejsi

je typicky dulezitejsi  je dobre volit 4-6, nekdy

je dobre volit 4-6, nekdy  , kde

, kde  je pocet priznaku

je pocet priznaku je dobre volit male, lze napr. volit prumernou vzdalenost bodu k jejich

je dobre volit male, lze napr. volit prumernou vzdalenost bodu k jejich  -temu sousedovi

-temu sousedovi- sum by mel byt mezi 1 % a 30 %

- neni dobre mit velke shluky (napr. pres 50 % velikosti datasetu)

Zaver silhouette skore

- pomoci

![s(x)_]() pro kazde

pro kazde  lze ted napriklad zpocitat prumerne silhouette skore pro shluk

lze ted napriklad zpocitat prumerne silhouette skore pro shluk  , znacime

, znacime

- nebo prumerne skore pro cele shlukovani, znacime

- porovnani

pro ruzne pocty shluku muzeme pouzit k nalezeni vhodneho poctu shluku

pro ruzne pocty shluku muzeme pouzit k nalezeni vhodneho poctu shluku  jako hodnoty, pri ktere je

jako hodnoty, pri ktere je  minimalni

minimalni

Analyza asociacnich pravidel

- cilem je nalezt spolecne hodnoty priznaku

- nalezeni oblasti prostoru, kde se data vyskytuji s velkou pravdepodobnost

- nalezeni oblasti prostoru, kde se data vyskytuji s velkou pravdepodobnost - mozne vyuziti je v doporucovacich systemech

- nejcasteji se zabyvame pouze oblastmi, ktere jsou ve tvaru kartezskeho soucinu pro jednotlive priznaky, tj. chceme, aby byla pravdepodobnost

relativne velka, tj. casto zkoumame kartezsky soucin spojitych podintervalu rozsahu jednotlivych priznaku (napr.

relativne velka, tj. casto zkoumame kartezsky soucin spojitych podintervalu rozsahu jednotlivych priznaku (napr.  pro priznak

pro priznak  a zaroven

a zaroven  pro priznak

pro priznak  )

) - prunik takovych podmnozin priznaku:

se nazyva konjunktivni pravidlo

se nazyva konjunktivni pravidlo

AdaBoost

1. Nastavme vahy rovnomerne, tedy  a polozme

a polozme

2. Pokud  :

:

Nauc strom  na datech

na datech  s vahami

s vahami

3. Do promenne  ulozme soucet vah tech bodu z

ulozme soucet vah tech bodu z  ,

,

ktere jsou spatne klasifikovane stromem

4. Pokud  :

:

Algoritmus skonci (vsechna data jsou natrenovana spravne)

a vrati rozhodovaci stromy

5. Polozme

kde  je hyperparametr modelu zabranujici preuceni

je hyperparametr modelu zabranujici preuceni

(pokud je mensi nez 1)

pokud je malo chyb ( ), pak

), pak

pokud je hodne chyb ( ), pak

), pak

6. Pro stromem  spatne klasifikovane body

spatne klasifikovane body  :

:

7. znormalizujeme vahy, aby jejich soucet byl 1

8. zvetsime  o jedna, vratime se do bodu 2

o jedna, vratime se do bodu 2

Maximalizace verohodnostni funkce

Binarni AAP

- casto se AAP aplikuje v pripade binarnich priznaku, tj.

- "analyza nakupniho kosiku" (ANK)

- "analyza nakupniho kosiku" (ANK) - pouziva se dalsi omezeni:

je bud jednoprvkova mnozina

je bud jednoprvkova mnozina  , nebo vsechny moznosti daneho priznaku

, nebo vsechny moznosti daneho priznaku  (priznak vypadne) - vybirame pouze priznaky s hodnotou 1, nikoli s hodnotou 0

(priznak vypadne) - vybirame pouze priznaky s hodnotou 1, nikoli s hodnotou 0 - ekvivalentne tedy hledame mnozinu indexu

tak, ze tato pravdedobnost je relativne velka:

tak, ze tato pravdedobnost je relativne velka:

- mnozina

se pak nazyva mnozina polozek

se pak nazyva mnozina polozek - relativni velikost polozek v datasetu, ktere danou mnozinu polozek obsahuji, se znaci

a nazyva podpora mnoziny polozek a odpovida odhadu vyse uvedene pravdepodobnosti:

a nazyva podpora mnoziny polozek a odpovida odhadu vyse uvedene pravdepodobnosti:

- tedy relativni velikost datasetu, ktere odpovidaji teto mnozine polozek

Hledani nad urcitou mez

Hledani gradientu

- tuto sumu (soucet) lze derivovat jako soucet derivaci (vnitrku sumy) pro kazde

, protoze se jedna o rozdil, muzeme oba cleny te vnejsi zavorky derivovat zvlast a odecist je od sebe

, protoze se jedna o rozdil, muzeme oba cleny te vnejsi zavorky derivovat zvlast a odecist je od sebe - pri pocitani parcialni derivace

:

:

Hranice

- resenim takove rovnice je nadrovina v prostoru

(bod v

(bod v  , primka pro

, primka pro  , rovina pro

, rovina pro  )

) - tato data musi byt hezky linearne separabilni, tj. existuje nadrovina, ktera je spolehlive oddeli na nuly a jednicky (ve 2D primka, ve 3D rovina atd.)

- napr. pokud mame dataset, kde data jsou rovnomerne rozdelena do nejake vzdalenosti od bodu

napr. s hodnotou

napr. s hodnotou  v prvnim a tretim kvadrantu, s hodnotou

v prvnim a tretim kvadrantu, s hodnotou  ve druhem a ctvrtem kvadrantu, nelze je nijak oddelit primkou!!!

ve druhem a ctvrtem kvadrantu, nelze je nijak oddelit primkou!!!

Pokracovani

Trenovani + predikce

Parametry modelu:

n: pocet lesu

k: pocet vybranych prvku

q: pocet nahodne vybranych priznaku

H: hyperparametry stromu

Trenovani(D: dataset) -> void:

1. for i = 1..n:

2. Di = []

3. Qi = vyber nahodnych q priznaku z priznaku D

4. repeat k times:

5. x = vyber nahodny prvek z D

6. Di.append(x.vyber_priznaky(Qi))

7. Ti = natrenuj strom s daty Di a hyperparametry H

Predikce(x: datovy bod) -> float

1. pro i = 1..n:

2. Yi = Ti.predict(x.vyber_priznaky(Qi))

3. return mean(Yi)

Predikce

1. Kazdemu stromu  prirad vahu

prirad vahu  z kroku 5 trenovaciho algoritmu

z kroku 5 trenovaciho algoritmu

2. Secti vahy  vsech stromu, ktere pro

vsech stromu, ktere pro  predikuji

predikuji

a to same udelej pro stromy predikujici  (vazena predikce)

(vazena predikce)

3. Rozhodni se pro tu z moznosti, pro kterou je soucet vah vyssi

Priklad

- asociacni pravidlo

- podpora

znamena, ze v celem datasetu si koupilo

znamena, ze v celem datasetu si koupilo  kombinaci vsech tri produktu

kombinaci vsech tri produktu - pokud se parky vyskytuji v

pripadu, pak spolehlivost se vypocita jako

pripadu, pak spolehlivost se vypocita jako

- tedy pokud si zakaznik koupi parky, pak v

pripadu si koupi i horcici a chleb

pripadu si koupi i horcici a chleb - pokud se horcice a chleb vyskytuji v

pripadu, zdvih bude

pripadu, zdvih bude

- tedy pokud si zakaznik koupi parek, pak je

vetsi sance, ze si koupi horcici a chleb, nez kdyby si parky nekoupil

vetsi sance, ze si koupi horcici a chleb, nez kdyby si parky nekoupil - pokryti je

, tedy ze

, tedy ze  lze horcici a chleb brat jako dusledek koupe parku

lze horcici a chleb brat jako dusledek koupe parku - nevyhoda na podporu je, ze pravidla s velkou hodnotou spolehlivosti i zdvihu, ale s nizkou podporou, nebudou nalezena, napr.

Hledani gradientu - pokracovani

, oznacme

plati

, kde

, tedy matice je pozitivne semi-definitni, pak nabyva funkce

v bode

ostreho lokalniho minima

, protoze

, plati:

si rozdelime na

podobne velkych

:

s hyperparametry

odhadni chybu jako

:

s nejlepsim

, ktere tvori disjunktni sjednoceni

?

a polozme

:

na datech

s vahami

ulozme soucet vah tech bodu z

,

:

je hyperparametr modelu zabranujici preuceni

), pak

), pak

spatne klasifikovane body

:

o jedna, vratime se do bodu 2

prirad vahu

z kroku 5 trenovaciho algoritmu

vsech stromu, ktere pro

predikuji

(vazena predikce)